中国企业数据治理联盟〔www.chinaedg.com/〕

进入》主数据管理 企业数据治理 信息资源规划 数据保障管理

维基百科对智能有如下定义:

智能是一种能够感知或推断信息,并将其作为知识遗留下来,自适应地用于某种环境或上下文本事,

人工智能〔Artificial Intelligence〕

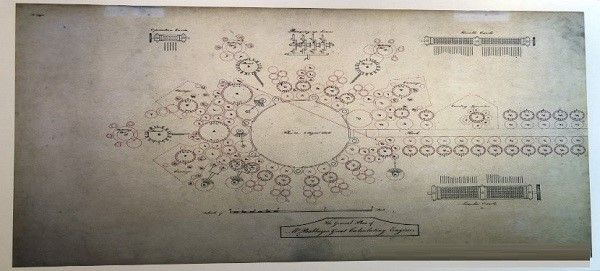

虽说咱们很难对人工智能做一個确切解释,但可以从查尔斯巴贝奇分析机讲起,它虽说没有任何特殊“自适应”本事,但却非常灵活,遗憾是,理论上虽说完美,但却没有得以实行,

巴贝奇分析机早图灵机50年左右发生,从理论上讲,它能够将任何可计算函数作为输入,并在百分之百机械情况下引发输出,

复杂性理论〔complexity theory〕由此得以发展,同时人们也意识到构建通用计算机其实相对简单,另外,算法实行也越发多样,纵然还存在一些技术上挑战,但在过去70年中,相同价格可购买到计算量大约每两年翻一番,

也就是说,构建计算力无敌人工智能系统越发容易,反而,这受到所供应或输入数据,以及搞定时间限制,可以做如下琢磨:倘若每台计算机本事都受到数据、时间限制,咱们还能称之为智能计算机么?

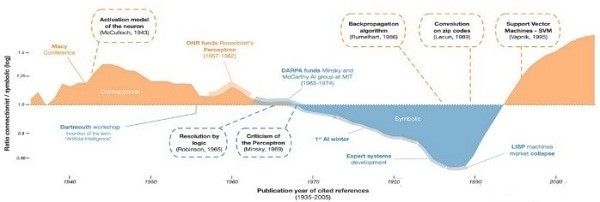

下面咱们简单回顾一下人工智能发展史,人类智能最先选涵盖归纳总结、逻辑演绎,对应着人工智能中联结主义〔如人工神经网络〕、符号主义〔如吴文俊方法〕,符号主义感觉智能是根据逻辑规则符号操作;联结主义感觉智能是由神经元构成信息搞定系统,其发展轨迹如下图所示:

联结主义,就“橙色阵营”在一开始处于最先进地位,得益于其与神经科学、人类大脑之间关系,人类大脑被视为“强AI〔Strong Artificial Intelligence〕”、“通用人工智能〔Artificial General Intelligence,AGI〕”唯一成功应用,反而,最先個代神经网络在搞定实际难题时屡屡受挫,因神经网络多数是线性,同时本事十分有限,深受外界质疑,与此同时符号主义,就“蓝色阵营”利用严谨数学理论创造出更多有用东西,

伴随手工知识积累,输入或输出数据量急速增长,系统性能无法适应需求,联结主义逐渐衰败,就好比法律,专家制定出再完备规则都有大概相互冲突,现在便须要越来越多“法官”来搞定这些难题,这减缓联结主义发展,

后来,“橙色阵营”获取足够标签数据、计算资源,能够在可接受时间内对网络实行“训练”,世界各地研究学者开始实行大量试用,纵然这般,联结主义仍花费大量时间使大众重新信任神经网络,开发者员也花较长才适应模糊逻辑、统计概念,

在对人工神经网络实行祥明讨论前,本文将先介绍一些其它方法:决策树、概率模型、进化算法,

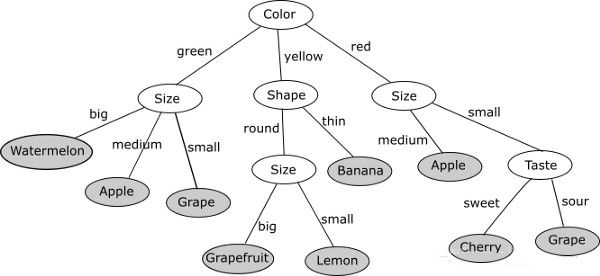

决策树〔Decision Tree〕是最简单有效算法之一,其“学习”是经由顺序地遍历数据每個属性并找到对特定输出具有最大占卜本事属性来执行,像随机森林这样高级变体运用更复杂学习技术,并在同一個模型中组合多個树,它们输出是经由“投票”得到,这与人类“直觉”类似,

概率模型〔Probabilistic models〕是统计方法代表,概率模型与神经网络常共享架构、学习/改良过程甚至符号,但是概率模型大多受概率逻辑〔往往是贝叶斯〕约束,而神经网络则无此约束,

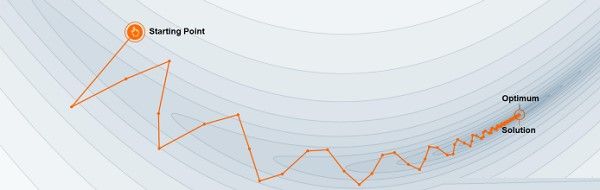

进化算法〔Evolutionary computation〕起初是受到生物进化启发,且以随机突变、适应度为主,由于修改往往是随机,其限制噪声疗效突出,进化算法是一种引导式搜索,很多方面与退火过程类似,

上述方法有一個一道点:它们从较差策略开始,逐渐对其改善,以期在某种性能评估方法中取得更非常好分数,

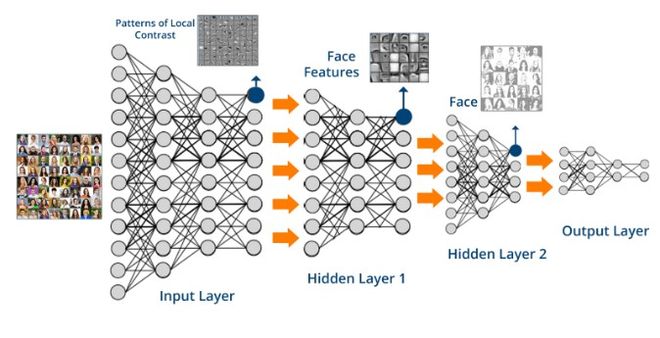

如今,机器学习技术,尤其是深度学习正在主导人工智能发展,与大多数运用1到2個中间抽象层〔所谓浅模型〕机器学习方法不同样,深度学习大概包含数百甚至数千個堆叠可训练层,

研究学者感觉对这样深度网络实行训练,须要全新改良程序,事实证明,运用梯度下降逆向传播〔就链式法则〕就可很非常好实行训练,也可运用Adam或RMSProp,

神经网络训练流程如下:

1、 获取输入

2、 计算输出

3、 评估性能

4、 调节参数

5、 重复训练,至性能最优

梯度下降法只需调整参数使误差最小,但该方法容易使网络陷入局部最优,而没有获得最优性能,反而,最新研究说明很多神经网络已经能够获取全局最优解,

深度学习实行训练并行化,就分布式学习,能在同一时间跨多台机器训练相同体系结构,同时实行梯度交换,加速超过1000倍,

另外,经过训练网络可以搞定相似任务,就迁移学习,这也是人工神经网络广泛流行要紧原因,比方说,经过图像分类训练网络可以用于其他计算机视觉任务,自然语言搞定、其他领域,更要紧是,同一個网络还可以用来搞定不同样模式难题,

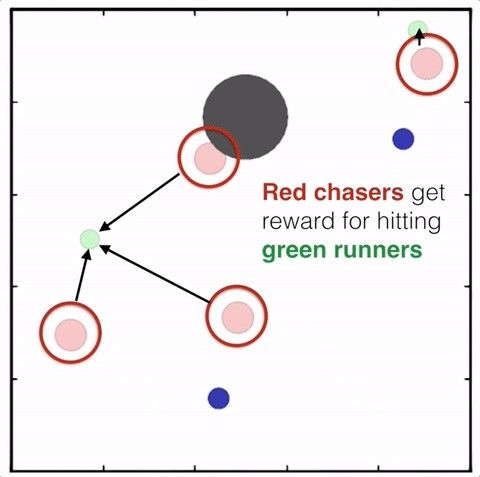

强化学习〔Reinforcement Learning,RL〕则将它们结合在一起,RL起初想法来自行为心理学,科研人员探究在行为心理学中奖励如何影响学习、塑造动物行为,

RL并非须要发生正确输入/输出对,也不须要精确校正次改良行为,举個例子,咱们并非须要教会机器人如何精确移动,只需根据它走多远或多快对其实行奖励,它会自己找出正确路线,反而,这种训练模式在实践中也是最具挑战性,就使是相对简单任务,往往也须要付出大量奋勉才干正确设置,

在实际难题中,往往很难在环境中指定奖励,研究人员目前更多地Follow内部奖励模型,

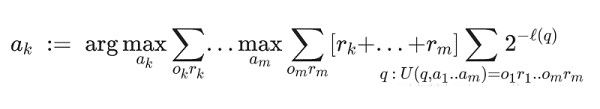

与RL并行是逆向强化学习〔Inverse Reinforcement Learning〕:当完成复杂任务时,强化学习回报函数很难指定,咱们希望有一种方法能够找到全效且权威回报函数,这种方法就是逆向强化学习,

通用人工智能中一些框架来自于严格数学理论,一些受神经元回路启发,还有一些根据心理模型,本文将以HTM、AIXI、ACT-R、SOAR为例实行介绍,

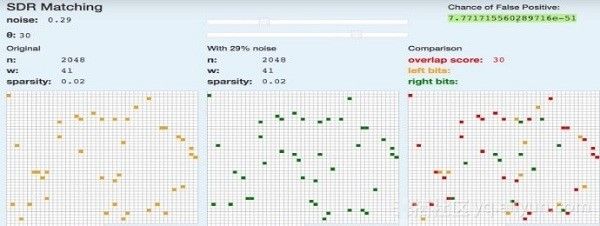

层级实时记忆算法 〔Hierarchical Temporal Memory,HTM〕,HTM算法旨在模拟新大脑皮层就业原理,将复杂难题转化为模式匹配与占卜,它着重对“神经元”实行分层级,以及信息模式空间特性与时间特性,

稀疏分布表达〔Sparse Distributed Representation, SDR〕是HTM算法中一個要紧概念,实际上,它只是持有几千個元素位数组,就像大脑中信息总是经由亿万神经细胞中小一部分活跃细胞来表达一样,HTM运用稀疏分布表达语义相关输入,

HTM算法中抑制〔Inhibition〕类似于批规范化、其他一些正则化技术,提升〔Boosting〕在机器学习中已经是一個相对较老概念,层次结构〔Hierarchical Structure〕并未真正大脑皮层结构灵活,HTM对物体间关系看重层次低,甚至连稀疏分布表达也可以用普通神经网络构建,总体上说,HTM须要实行大量调整才干获取与其它机器学习算法相当性能,

接下来介绍AIXI,它是一個对通用人工智能理论上数学格局化表达,反而,它有一個显著缺点——无法计算,事实上,很多机器学习算法均无法精确计算,只能做近似搞定,AIXI表达如下:

AIXI重心是一個强化学习智能体,在诸多方面与Schmidhuber开发Godel Machine类似,反而,它们都是AGI描述性模型,复杂层次高,无法执行,但无法否认,它们都是人工智能研究人员灵感源泉,

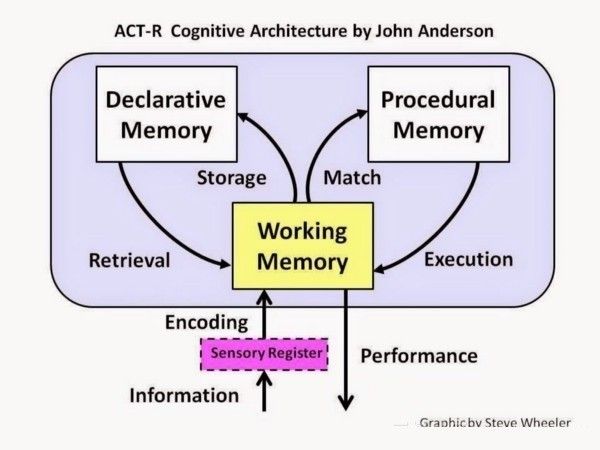

相反,ACT-R,就理性思维自适应控制系统 〔AdaptiveControl of Thought—Rational〕,它不光是一种理论,况且是一种用LISP编写软件框架,

ACT-R最先选Follow不同样类型内存,较少Follow其中数据转换,该理论试图理解人类如何获得、组织知识以及如何引发智力活动,其研究进展根据神经生物学研究成果并从中得以验证,且已成功地为很多不同样认知现象奠定起合理模型,反而,它在实际应用中并未取得成功,最后只作为研究人员工具,SOAR与ACT-R有着相似根源、基本假设,但它更Follow于实行AGI,而不是奠定人类认知模型,

ACT-R、SOAR是人工智能符号主义经典代表,在认知科学发展中起到要紧作用,但是应用它们相比现代联结主义须要更多配置、先验知识,另外,神经影像、其他用于心智研究工具越发祥明、准确,况且ACT-R、SOAR在某一定层次上过于僵化,无法维持相关性。

作者信息

Egor Dezhic

文章原标题《What is Intelligence?》,译者:Elaine

编辑:hely 来源:网络大数据