点击上方“CSDN”,选择“置顶公众号”

根本时刻,最先個时间送达!

作者 | 张俊林

责编 | 何永灿

人工智能最近三年发展如火如荼,学术界、工业界、投资界各方一起发力,硬件、算法与数据一道发展,不光是大型互联网公司,涵盖大量创业公司以及传统行业公司都开始涉足人工智能,

2017年人工智能行业延续2016年旺盛发展势头,那么在过去一年里AI行业从技术发展角度有哪些要紧进展?后世又有哪些发展势头?本文从大家相对Follow若干领域作为代表,来归纳AI领域一些方向要紧技术进展,

从AlphaGo Zero到Alpha Zero:迈向通用人工智能根本一步

DeepMind携深度增强学习利器总是能够给人带来震撼性技术独创,2016年横空出世AlphaGo百分之百粉碎普遍存在“围棋领域机器无法战败人类最大层次手”执念,但是到底李世石还是赢一局,很多人对于人类翻盘大逆转还是抱有希望,紧接着Master经由60连胜诸多鼎级围棋高手百分之百浇灭这种期待,

2017年AlphaGo Zero作为AlphaGo二代做进一步技术升级,把AlphaGo一代虐得体无完肤,这时候人类已经没有资格上场对局,2017年底AlphaGo棋类游戏通用版本Alpha Zero问世,不光围棋,对于国际级象棋、日本将棋等其他棋类游戏,Alpha Zero也以压倒性优点战胜涵盖AlphaGo Zero在内目前最大层次AI程序,

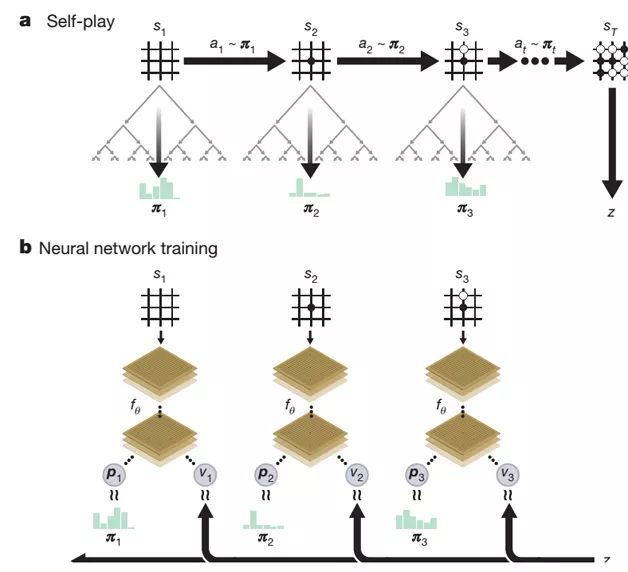

图1 AlphaGo Zero自我对弈及训练过程

AlphaGo Zero从技术手段上、AlphaGo相比并未有本质上改进,主体依旧是MCST蒙特卡洛搜索树加神经网络结构以及深度增强学习训练方法,但是技术实行上简单优雅很多〔参考图1〕,最先选改动包含两处:一处是将AlphaGo两個占卜网络〔策略网络、价值网络〕合并成一個网络,但是同时引发两类所需输出;第二处是网络结构从CNN结构升级为ResNet,

虽说这般,AlphaGo Zero给人带来触动、启发丝毫不及AlphaGo少,最先选原因是AlphaGo Zero百分之百放弃从人类棋局来实行下棋经验学习,直接从一张白纸开始经由自我对弈方法实行学习,并仅仅经由三天自我学习便获得远超人类千年积累围棋经验,

这引发一個之前一般人很期待但是同时又感觉很难完成难题:机器能够不依赖有监督方法训练数据或者极少训练数据自我进化与学习吗?倘若真能够做到这一点,那么是否意味着机器会高速进化并淘汰人类?第二個难题甚至会引起一部分人恐慌,但是其实这個难题自身问就有难题,因它做一個错误假设:AlphaGo Zero是不须要训练数据,先说,AlphaGo Zero确实做到经由自我对弈方法实行学习,但是依旧须要大量训练数据,无非这些训练数据是经由自我对弈来引发,况且更根本一点是应该意识到:对于AlphaGo Zero来说,其本质其实还是MCST蒙特卡洛树搜索,围棋之所以看着难度大难以克服,最先选是搜索空间实在太大,单纯靠暴力搜索百分之百无法行,倘若咱们假设现在有個机器无限无敌,能够高速遍历所有搜索空间,那么其实单纯运用MCST树搜索,不依靠机器学习,机器也能达到完美博弈状态,

AlphaGo Zero经由自我对弈以及深度增强学习最先选达到能够更好地评估棋盘状态、落子质量,优先选择走那些赢面大博弈路径,这样能够舍弃大量劣质路径,于是极大减少须要搜索空间,自我进化最先选体现在评估棋面状态越来越准,而之所以能够经由自我对弈引发大量训练数据,是因下棋是個规则定义很清晰任务,到一定状态就能够赢或者输,无非这种最后赢或者输来得晚一些,不是每一步落子就能看到,现实生活中任务是很难达到这一点,这是为何很多任务依旧须要人类供应大量训练数据原因,倘若从这個角度探究,就不会错误地引发以上疑虑,

Alpha Zero相对AlphaGo Zero则更进一步,将只能让机器下围棋拓展到能够实行规则定义清晰更多棋类难题,使得这种技术往通用人工智能路上迈出要紧一步,其技术手段、AlphaGo Zero基本是相同,只是去除掉所有跟围棋有关一些搞定措施、技术手段,只告诉机器游戏规则是什么,而后运用MCST树搜索+深度神经网络并结合深度增强学习自我对弈统一技术方案、训练手段搞定一切棋类难题,

从AlphaGo一步步进化策略可以看出,DeepMind正在探究这套扩展技术方案通用性,使得它能够运用一套技术搞定更多难题,尤其是那些非游戏类真实生活中有现实价值难题,同时AlphaGo系列技术也向机器学习从业人员展示深度增强学习无敌威力,并进一步推动相关技术进步,目前也可以看到深度增强学习在更多领域应用实例,

GAN:前景广阔,理论与应用极速发展中

GAN,全称为Generative Adversarial Nets,直译为“生成式对抗网络”,GAN作为生成模型代表,自2014年被Ian Goodfellow提出后引起业界广泛Follow并非断涌现出新改进模型,深度学习泰斗之一Yann LeCun高度评价GAN是机器学习界近十年来最有意思想法,

Ian Goodfellow提出起初GAN纵然从理论上证明生成器、判别器在多轮对抗学习后能够达到均衡态,使得生成器可以引发理想图像结果,但是实际上,GAN始终存在训练难、定鼎性差以及模型崩塌〔Model Collapse〕等难题,引发这种不匹配根本原因其实还是对GAN背后引发作用理论机制没有探索清楚,

过去一年在如何增加GAN训练定鼎性及搞定模型崩塌方面有可喜进展,GAN本质上是经由生成器、判别器实行对抗训练,逼迫生成器在不知晓某個数据集合真实分布Pdata情形下,经由连续调整生成数据分布Pθ去拟合逼近这個真实数据分布Pdata,所以计算当前训练过程中两個分布Pdata、Pθ距离度量准则就很根本,

Wasserstein GAN作者敏锐地指出:原始GAN在计算两個分布距离时采用是Jensen-Shannon Divergence〔JSD〕,它本质上是KL Divergence〔KLD〕一個变种,JSD或者KLD存在一個难题:当两個分布交集很少时或者在低维流形空间下,判别器很容易找到一個判别面将生成数据、真实数据区分开,这样判别器就无法供应有效梯度信息并反向传导给生成器,生成器就很难训练下去,因缺乏来自判别器指导改良意向,Wasserstein GAN提出运用Earth-Mover距离来代替JSD准则,这很大层次上改进GAN训练定鼎性,后续Fisher GAN等模型又对Wasserstein GAN实行进一步改进,这些技术陆续改善GAN训练定鼎性,模型崩塌也是严重制约GAN疗效难题,它指是生成器在训练好之后,只能引发固定几個模式图片,而真实数据分布空间其实是很大,但是模型崩塌到这個空间若干個点上,最近一年针对这個难题也提出比方说标签平滑、Mini-Batch判别器等启发式方法来搞定生成器模型崩塌难题并取得一定疗效,

纵然在理论层面,针对GAN存在难题,业界在2017年提出很多改进方法,对于GAN内在就业机制也有更深入解,但是很明显目前依旧没有理解其本质就业机制,这块还须要后世更有洞察力就业来增进咱们对GAN理解,

图2 运用CycleGAN将照片中猫换成狗

GAN具备非常广泛应用场景,比方说图像风格转换、超分辨率图像构建、自动黑白图片上色、图片实体属性编辑〔比方说自动给人像增加胡子、切换头发颜色等属性变换〕,不同样领域图片之间转换〔比方说同一個场景春天图片自动转换为秋天图片,或者白天景色自动转换为夜间景色〕,甚至是图像实体动态替换,比方说把一幅图片或者影像中发生猫换成狗〔参考图2〕,

在推动GAN应用方面,2017年有两项技术是非常值得Follow,其中一個是CycleGAN,其本质是利用对偶学习并结合GAN机制来改良生成图片疗效,采纳类似思想涵盖DualGAN以及DiscoGAN;涵盖后续很多改进模型比方说StarGAN等,CycleGAN要紧性最先选在于使得GAN系列模型不再局限于监督学习,它引入无监督学习方法,只要准备两個不同样领域图片集合就可,不须要训练模型所需两個领域图片一一对应,这样极大扩展它运用范围并降低应用普及难度,

另外一项值得Follow技术是英伟达采纳“渐进式生成”技术路线GAN方案,这项方案引人之处于于使得计算机可以生成1024*1024大小高清图片,它是目前任凭图像清晰度还是图片生成质量都达到最卓著疗效技术,其生成明星图片接近可以达到以假乱真疗效〔参考图3〕,英伟达这项由粗到细,先说生成图像模糊轮廓,再逐步添加细节思想其实并非极具新颖思路,在之前StackGAN等很多方案都采用类似思想,它前无古人后无来者之处于于这种由粗到细网络结构是动态生成而非事先固定静态网络,更根本是引发图片疗效极具好,

图3 英伟达提出渐进生成式GAN引发高清头像图片

总而言之,以GAN为代表生成模型在2017年任凭是理论基石还是应用实践都引发很大技术进展,可以预计是它会以越来越快速度获得研发人员推动,并在不远将来在各個须要创造性领域获得广泛应用,

Capsule:有望取代CNN新结构

Capsule今年才以论文格局被人称“深度学习教父”Hinton老先生发表出现,况且论文一出现就变成研究人员Follow焦点,但是其实这個思想Hinton已经深入琢磨很久同时之前在各类场合宣传过这种思路,Hinton一直对CNN中Pooling操作意见很大,他过去吐槽说:“CNN中运用Pooling操作是個大错误,事实上它在实际运用中疗效还没错,但这其实更是一场灾难”,那么,MaxPooling有什么难题值得Hinton对此深恶痛绝呢?参照图4所示例子可以看出其原因,

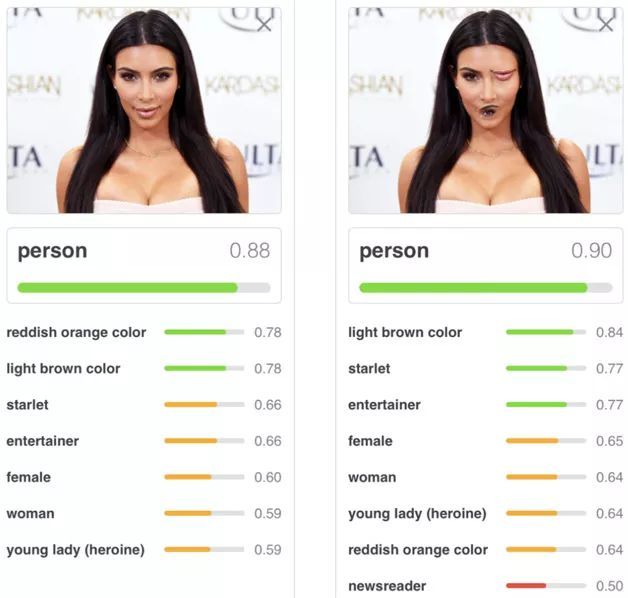

图4 CNN图像分类

在上面这张图中,给出两张人像照片,经由CNN给出照片所属类别及其对应概率,最先個张照片是一张正常人脸照片,CNN能够正确识别出是“人类”类别并给出归属概率值0.88,第二张图片把人脸中嘴巴、眼睛对调下位置,对于人来说不会感觉这是一张正常人脸,但是CNN依旧识别为人类况且置信度不降反增为0.90,为什么会发生这种、人直觉不符现象?这個锅还得MaxPooling来背,因MaxPooling只对某個最大层次特征做出反应,至于这個特征发生在哪里以及特征之间应该维持什么样合理组合关系它并非关心,总而言之,它给CNN“位置固定性”太大自由度,所以造成以上不符合人类认知判断结果,

在Capsule方案中,CNN卷积层保留,MaxPooling层被拿掉,这里须要着重是,Capsule自身是一种技术框架,并非单单是具体某项技术,Hinton论文给出是最简单一种实行方法,百分之百可以在遵循其技术思路情况下创造全新具体实行方法,

要理解Capsule思路或者对其做一個新技术实行其实也不困难,只要理解其中几個根本环节就能实行此目,倘若用一句话来说明其中根本点话,可以用“一個腹地,两個基本点”来概括,

这里一個腹地,指是Capsule重心目是希望将“视角固定性”本事引入图像搞定系统中,所谓“视角固定性”,指是当咱们给3D物体拍照片时候,镜头所对一定是物体某個角度看上去样子,也就是2D照片体现3D物体一定是体现出镜头、3D物体某個视角角度,而不是360度物体全貌,那么,要达到视角固定性,就是希望给定某個物体某個角度2D照片,当看到另外一张同一物体不同样视角2D照片时,希望CNN也能识别出其实这依旧是那個物体,这就是所谓“视角固定性”〔参照图5,上下对应图片代表同一物体不同样视角〕,这是传统CNN模型很难做非常好事情,

图5 视角固定性

至于说两個基本点,先说最先個個基本点是:用一维向量或者二维数组来表征一個物体或者物体某個部件,传统CNN纵然也能用特征来表征物体或者物体构成部件,但是往往是经由不同样层级卷积层或者Pooling层某個神经元是否被激活来体现图像中是否具备某個特征,Capsule则探究用更多维信息来记载并表征特征级其他物体,类似于自然语言搞定中运用Word Embedding表征一個单词语义,这样做好处是描述物体属性可以更加细致,比方说可以将物体纹理、速度、方向等作为描述某個物体具体属性,

第二個基本点是:Capsule不同样层间神经元之间动态路由机制,具体而言是低层神经元向高层神经元传递信息时动态路由机制,低层特征向高层神经元实行动态路由本质上是要体现如下思想:构成一個物体组成部件之间会经由协同地相互增强方法来体现这种“整体-组成一部分”关系,比方说纵然图片视角发生变换,但是对一個人脸来说,嘴、鼻子等构成人脸构件会协同地发生类似视角变换,它们依旧组合在一起构成从另外一個视角看过去人脸,倘若从本质上来说,动态路由机制其实是组成一個物体构件之间特征聚类,经由聚类方法把属于某個物体组成一部分动态地自动找出现,并奠定特征“整体-一部分”层级构成关系〔比方说人脸是由鼻子、嘴、眼睛等部件构成〕,

以上所述三個方面是深入理解Capsule根本,Capsule论文发出现后引发大量Follow、讨论,目前关于Capsule计算框架,大一部分人持赞赏态度,显然也有一些研究人员提出质疑,比方说论文中采用MINST数据集规模小不够复杂、Capsule性能优点不明显、消耗较多内存计算速度慢等,但是任凭这项新计算框架能否在后世取代CNN准则模型,抑或它很快会被人抛弃并遗忘,Hinton老先生这种老而弥坚求真治学态度,以及勇于推翻自己构建技术体系勇气,这些是值得所有人敬佩、学习,

CTR预估:向深度学习实行技术升级

CTR预估作为一個偏应用技术方向,对于互联网公司而言应该是最要紧也最Follow方向之一,道理很简单,目前大型互联网公司绝大多数利润都来源于此,因这是计算广告方向最最先选技术手段,从计算广告角度讲,所谓CTR预估就是对于给定运用者User,在特定上下文Context下,倘若展示给这個运用者某個广告或者产品Product,估算运用者是否会点击这個广告或者是否会购买某個产品,就求点击概率P〔Click|User,Product,Context〕,可以看到,这是個适用范围很广技术,很多专家推荐场景以及涵盖目前相对火信息流排序等场景都可以转换为CTR预估难题,

CTR预估常用技术手段涵盖演进路线一般是根据:“LR→GBDT等树模型→FM因子分解机模型→深度学习”这個路径来发展,深度学习在图像影像、语音、自然语言搞定等领域最近几年获得飞速进展,但是最近一两年学术界才开始相对频繁地陆续发生深度学习如何、CTR预估相结合文章,Google最新在几年前就开始研究这方面内容,之后国内大型互联网公司也开始跟进,

CTR预估场景有自己前无古人后无来者应用特点,而想要用深度学习搞定CTR预估难题,必需探究如何融入、体现这些特点,咱们晓得,DNN模型利于搞定连续数值型特征,而图像语音等纯天然满足这一条件,但是CTR预估场景会包含大量离散特征,比方说一個人性别、毕业学校等都属于离散特征,所以用深度学习做CTR预估先说要搞定难题是如何表征离散特征,一种常见方法是把离散特征转换为Onehot表达,但是在大型互联网公司应用场景下,特征维度都是千亿价值以上级其他,倘若采用Onehot表征方法,意味着网络模型会包含太多参数须要学习,所以目前主流深度学习搞定方案都采用将Onehot特征表达转换为低维度实数向量〔Dense Vector,类似于NLP中Word Embedding〕思路,这样可以大量降低参数规模,另外一個CTRFollow重心是如何实行自动特征组合难题,因非常好特征组合对于性能影响非常根本,而深度学习纯天然具有端对端优点,所以这是神经网络模型能够自然发挥作用地方,能够无需人工介入自动找到非常好特征组合,这一般体现在深度CTR模型Deep网络一部分,

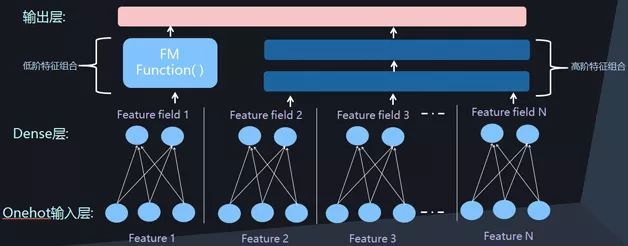

图6 并行深度CTR网络结构

图7 串联深度CTR网络结构

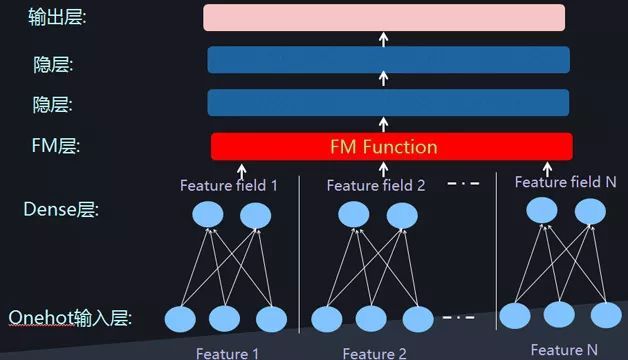

除更早一些流传甚广Wide&Deep模型,最近一年发生一些新深度CTR模型,比方说DeepFM、DeepCross、NFM模型等,这些模型其实倘若仔细实行分析,会发现它们在网络结构上存在极大相似性,除在网络结构上体现上述两個特点:一個是Dense Vector表达离散特征,另外一個是利用Deep网络对特征组合实行自动建模外,另外一個主流特点是将低维特征组合、高维特征组合在网络结构上实行分离,Deep网络体现高维度特征组合,而引入神经网络版本FM模型来对两两特征组合实行建模,这三個网络结构特点基本囊括目前所有深度CTR模型,图6、图7是两种常见深度CTR网络结构,目前所有模型基本都采用其中之一种结构,

计算机视觉:平稳发展一年

计算机视觉是AI领域最要紧研究方向之一,它自身又包含诸多研究子领域,涵盖物体分类与识别、意向检测与追踪、语义分割、3D重建等一些基石方向,也有超分辨率、图片影像描述、图片着色、风格迁移等偏应用方向,目前计算机视觉搞定主流技术中,深度学习已经占据绝对优点地位,

对于物体识别、意向检测与语义分割等基石研究领域来说,Faster R-CNN、SSD、YOLO等技术依旧是业界最先进最主流技术手段,在2017年新发生要紧技术中,Facebook何恺明等提出Mask R-CNN获得ICCV2017最优论文,它经由对Faster R-CNN增加分支网络改进方法,同时完成物体识别、意向检测与语义分割等基石任务,这展示运用同一套技术同时搞定多個基石领域难题大概性,并会促进后续相关研究继续深入探索;而YOLO9000以及同样是何恺明团队在论文“Learning to Segment Every Thing”提出MaskX R-CNN则体现基石领域另外一個要紧发展势头:尝试经由技术手段自动识别出更多种类物品,终极意向是能够识别任何物体,

目前MaskX R-CNN能够识别超过3000种类别物体,而YOLO9000则能够识别超过9000种物体类别,很明显,意向检测要在各类现实领域大规模获得运用,除速度快、识别精准外,能够大量识别各类现实生活中各类各样物体类别也是至关要紧,而最近一年研究在这方面引发要紧进展,

从网络模型结构来说,2017年并未引发类似之前ResNet这种引发巨大影响新模型,ResNet因其明显性能优点已经广泛运用在视觉搞定各個子领域中,虽说DenseNet获得CVPR2017最优论文,但它本质上是对ResNet改进模型,并非全新思路新模型,

除上述所说视觉搞定基石研究领域,倘若对2017年新技术实行归纳话,在很多其他应用领域也可以看到如下一些明显发展势头:

先说,增强学习与GAN等新技术开始被尝试用来搞定很多其它图像搞定领域难题并取得一定进展,比方说Image-Caption、超分辨率、3D重建等领域,开始尝试引入这些新技术,另外,深度学习与传统方法如何集成各自优点并深度融合也是最近一年来视觉搞定方向,深度学习技术具有性能优异等优点,但也存在黑箱无法解释以及理论基石薄弱等缺点,而传统方法具备理论完备等优点,结合两者来百分之百发挥各自优点克服自身缺点是很要紧,再次,弱监督、自监督或者无监督方法在各個领域也越来越要紧,这是有现实需求,深度学习虽说疗效好,但是对于大量标注训练数据是有要求,而这又须要大量标注本钱,在现实中往往无法行,而探索弱监督、自监督甚至无监督方法有助于更快促进各個领域研究高速发展,

自然语言搞定:进展相对缓慢,急需技术突破

自然语言搞定也是人工智能要紧方向之一,最近两年深度学习也已经基本渗透到自然语言搞定各個子领域并取得一定进展,但是与深度学习在图像、影像、音频、语音识别等领域取得强势进展相比,深度学习带给自然语言搞定技术红利相对有限,相比传统方法而言,其疗效并未取得压倒性优点,至于引发这种现象原因其实是個值得深入探讨难题,关于其原因目前众说纷纭,但并未有极具有说服力解释能够被大多数人所接受,

与一年甚至两年前相比,目前在自然语言搞定领域应用最主流深度学习基本技术工具并未发生巨大更迭,最主流技术手段依旧是以下技术组合大礼包:Word Embedding、LSTM〔涵盖GRU、双向LSTM等〕、Sequence to Sequence框架以及Attention注意力机制,可以在大量自然语言搞定子领域看到这些技术构件组合及其改进变体模型,CNN在图像领域占据压倒性优点,但是自然语言搞定领域依旧是RNN主导局面,纵然Facebook一直大力倡导根据CNN模型来搞定自然语言搞定,除在大规模分布式高速计算方面CNN确实相对RNN具备纯天然优点外,目前看不出其具备取代RNN主导地位其它前无古人后无来者优点,

最近一年深度学习在自然语言搞定领域应用有以下几個值得Follow发展势头,先说,无监督模型与Sequence to Sequence任务融合是個很要紧进展、发展方向,比方说ICLR 2018提交论文“Unsupervised Machine Translation Using Monolingual Corpora Only”作为代表技术思路,它运用非对齐双语训练语料集合训练机器翻译系统并达到较非常好疗效,这种技术思路本质上是、CycleGAN非常类似,相信这种无监督模型思路在2018年会有大量跟进研究,增强学习以及GAN等最近两年相对热门技术如何、NLP实行结合并真正发挥作用是個相对有前景方向,最近一年开始发生这方面探索并取得一定进展,但是很明显这条路还没有走通,这块值得继续实行深入探索,再次,Attention注意力机制进一步广泛运用并引入更多变体,比方说Self Attention以及层级Attention;从Google做机器翻译新论文“Attention is all you need”技术思路可以明显体会这個势头,另外,如何将一些先验知识或者语言学相关领域知识、神经网络实行融合是個相对流行研究势头,比方说将句子句法结构等信息明确引入Sequence to Sequence框架中等,另外外,神经网络可解释性也是一個研究热点,但是这一点不光局限在NLP领域,在整個深度学习领域范围也是非常Follow研究势头,

本文选择若干具有较高Follow度AI技术领域来阐述最近一年来该领域要紧技术进展,受作者本事以及平常最先选Follow领域限制,难免挂一漏万,很多方面要紧技术进展并未列在文中,比方说Google在力推TPU为代表AI芯片技术高速发展,让机器自动学习设计神经网络结构为代表“学习一切”以及搞定神经网络黑箱难题可解释性等很多要紧领域进展都未能在文中提及或展开,这些都是非常值得FollowAI技术发展方向,

过去一年AI很多领域发生重大技术进展,也有很多领域前进步伐缓慢,但是任凭如何,本文作者相信AI在后世若干年内会在很多领域引发颠覆目前人类想象力技术进步,让咱们期待这一天早日到来!

作者简介:张俊林,中科院软件所博士,曾担任阿里盼望、百度、用友等公司资深技术专家及技术总监职位,目前在新浪微博AI实验室担任资深算法专家,Follow深度学习在自然语言搞定方面应用,

本文为《程序员》原创文章,未经允许无法转载。